Conformité RGPD et Chatbots B2B : Les 4 erreurs à éviter pour un déploiement sécurisé de l’IA

L’IA conversationnelle s’impose dans les entreprises : support client, qualification des leads, agents internes, automatisation des appels… Mais avec cette adoption accélérée arrive un enjeu critique pour le B2B : la conformité RGPD.

Et la réalité est brutale :

👉 70 % des entreprises déploient un chatbot IA sans respecter toutes les obligations de conformité, souvent par manque d’information ou par excès de confiance dans l’outil choisi.

👉 25 % découvrent leurs erreurs au moment d’un contrôle, d’un audit client ou d’un incident.

Pourtant, la conformité n’a rien de complexe ou de coûteux… à condition d’éviter les 4 erreurs les plus fréquentes, qui peuvent coûter cher :

-

perte de clients B2B,

-

rupture de contrat,

-

sanctions CNIL,

-

atteinte à la réputation,

-

arrêt immédiat d’un déploiement IA,

-

fuite de données ou traitement illicite,

-

perte de la confiance interne.

Ce guide BotIA.ai vous explique comment éviter ces erreurs et comment déployer un chatbot IA 100 % compatible RGPD, transparent et sécurisé.

❌ Erreur n°1 : Croire que “le fournisseur IA est responsable de la conformité”

C’est l’erreur la plus dangereuse.

Les entreprises pensent souvent : “J’utilise un chatbot IA hébergé chez un fournisseur sérieux, donc il est RGPD compliant.”

Mais en réalité…Vous restez responsable du traitement des données

En RGPD, l’entreprise est responsable de traitement, même si :

-

le modèle IA est hébergé ailleurs,

-

les données transitent par une API,

-

le fournisseur assure une partie de la sécurité.

Ce que cela implique :

➡️ vous devez définir clairement les finalités,

➡️ vous devez documenter les données traitées,

➡️ vous devez garantir la base légale,

➡️ vous devez pouvoir justifier chaque traitement.

Le fournisseur IA n’est responsable que de :

-

ses infrastructures,

-

sa sécurité interne,

-

ses modèles.

Vous êtes responsable de l’usage que vous en faites.

❌ Erreur n°2 : Laisser le chatbot accéder à trop de données (ou à des données non nécessaires)

Avec les modèles génératifs, l’erreur classique est la surexposition des données internes.

Beaucoup d’entreprises donnent au chatbot IA :

-

tout le CRM,

-

les fiches clients complètes,

-

l’historique commandes complet,

-

des tickets internes sensibles,

-

des données RH ou financières.

Cela pose trois risques majeurs :

🧨 Risque de divulgation involontaire

Un chatbot mal paramétré peut répondre : “Voici le numéro de portable privé du client X”.

🧨 Risque de traitement illégal

Le RGPD impose la règle de minimisation :

➡️ le chatbot ne doit voir que les données strictement nécessaires.

🧨 Risque de fuite en cas de mauvaise configuration

Même sans piratage, un mauvais prompt peut exposer des données non pertinentes.

👉 Un bon chatbot IA n’a pas besoin d’accéder à tout.

👉 Un Agent IA moderne utilise des connexions limitées, précises et contrôlées.

❌ Erreur n°3 : Ne pas maîtriser où les données transitent réellement

Beaucoup d’entreprises ne savent pas :

-

où les données sont hébergées,

-

si elles sortent de l’UE,

-

si elles sont stockées temporairement,

-

qui y a accès chez le fournisseur,

-

si les logs contiennent des données personnelles.

Or, c’est un point central du RGPD :

✔ Localisation données

L’entreprise doit pouvoir garantir :

➡️ si les données restent dans l’UE,

➡️ si des transferts hors UE existent (et à quelles conditions).

✔ Conservation / rétention

Le RGPD impose que les données ne soient pas conservées plus longtemps que nécessaire.

Un bouton “Delete history” sur un chatbot public n’est pas conforme si :

-

les logs restent accessibles,

-

les données sont dupliquées ailleurs,

-

les données sont envoyées à des sous-traitants.

✔ Traçabilité

L’entreprise doit savoir :

➡️ qui a consulté les logs,

➡️ quand,

➡️ pourquoi,

➡️ et avoir une piste d’audit.

❌ Erreur n°4 : Ne pas documenter le cadre de traitement IA (DPIA, registre, risques)

La conformité n’est pas qu’un enjeu technique, c’est aussi un enjeu documentaire. Les entreprises oublient souvent de réaliser :

📌 Registre de traitement

Obligatoire pour tout traitement de données personnelles.

📌 DPIA (Analyse d’impact)

Obligatoire dès que l’IA traite :

-

des volumes significatifs,

-

des données sensibles,

-

des données d’identification,

-

ou réalise des actions automatiques (comme le Callbot).

📌 Politique interne IA

Document qui décrit :

-

ce que l’IA peut faire,

-

ce qu’elle ne peut pas faire,

-

qui supervise,

-

comment les décisions sont contrôlées.

📌 Documentation de transparence

À fournir aux utilisateurs finaux :

-

finalités,

-

type de données,

-

durée de conservation,

-

droit d’opposition.

➡️ Sans cette documentation, un audit CNIL peut sanctionner même si la solution technique est “propre”.

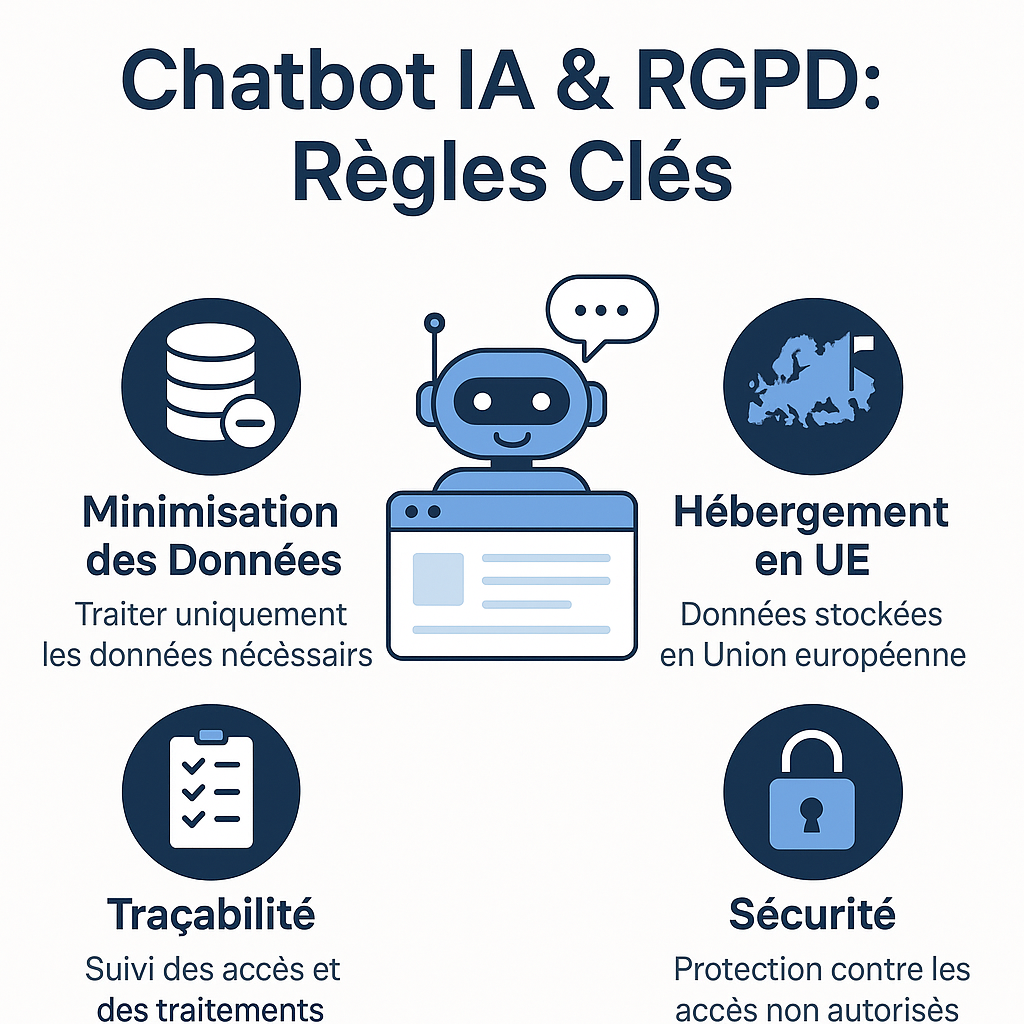

Les bonnes pratiques BotIA.ai pour un chatbot IA 100 % conforme RGPD

Voici les règles que nous appliquons systématiquement lors de chaque projet IA.

Principe de minimisation

Le chatbot ne voit que :

-

les données nécessaires

-

au moment où elles sont nécessaires

-

et seulement pour l’action demandée

Pas plus.

Conteneurisation des contextes

Toutes les sessions IA sont isolées, impossible pour le chatbot A de récupérer le contexte du chatbot B.

RAG sécurisé (pas d’entraînement sur vos données)

Les données internes sont utilisées :

✔ temporairement

✔ à la demande

✔ sous forme de contexte

❌ jamais pour entraîner le modèle

Hébergement en UE + contrôle des flux

Nous assurons :

-

hébergement européen conforme,

-

API filtrées,

-

logs anonymisés.

Traçabilité et supervision humaine

Chaque agent IA BotIA peut :

-

générer un log clair,

-

être supervisé en direct,

-

alerter l’équipe “humaine” en cas de risque.

Politique explicite de non-rétention

Par défaut :

➡️ aucun message n’est stocké en dehors de l’entreprise

➡️ pas de logs avec données personnelles

➡️ pas de réutilisation externe

Et surtout : un chatbot IA conforme… rassure les clients B2B

Un chatbot sécurisé n’est pas seulement un “besoin légal”.

C’est un avantage commercial :

-

Les grandes entreprises vous feront davantage confiance

-

Les DSI / DPO valident plus vite vos projets

-

Vous pouvez gérer des données sensibles

-

Vous réduisez les risques internes

-

Vous valorisez votre expertise dans un contexte IA sensible

Les entreprises qui mettent la conformité au cœur de leur stratégie IA signent plus facilement, plus rapidement, avec des clients plus grands.

Conclusion : la conformité n’est pas un frein — c’est un accélérateur de confiance

Les chatbots génératifs et agents IA peuvent être 100 % conformes au RGPD.

À condition de maîtriser :

✔ la gouvernance

✔ l’accès aux données

✔ la documentation

✔ la minimisation

✔ l’hébergement

✔ la traçabilité

✔ la sécurité interne

La conformité n’est pas un obstacle. C’est un levier de crédibilité et de performance B2B, indispensable en 2025–2026.